Directional Alignment Instance Knowledge Distillation for Arbitrary-Oriented Object Detection

Introduction

论文题目 :Directional Alignment Instance Knowledge Distillation for Arbitrary-Oriented Object Detection

论文地址 :https://ieeexplore.ieee.org/abstract/document/10227337/

论文出处 :2023’TGARS

代码实现:未公开

Idea

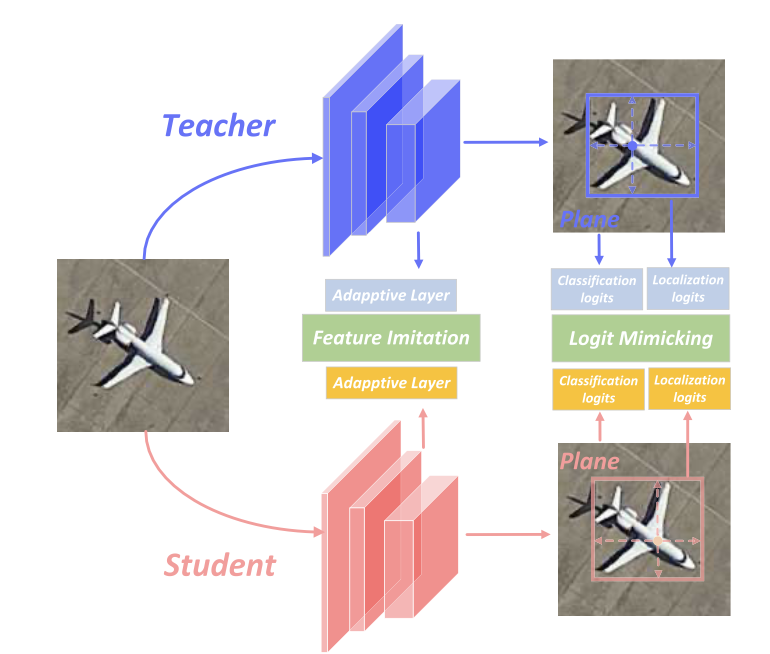

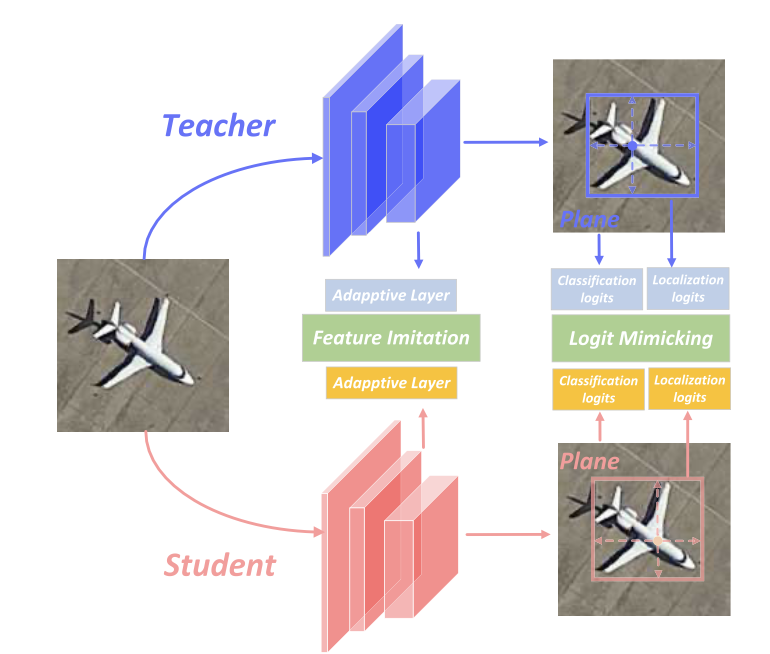

遥感目标检测方向专门的知识蒸馏。

Detail

选择了YOLOv6中提出的Efficient Rep作为backbone和neck.

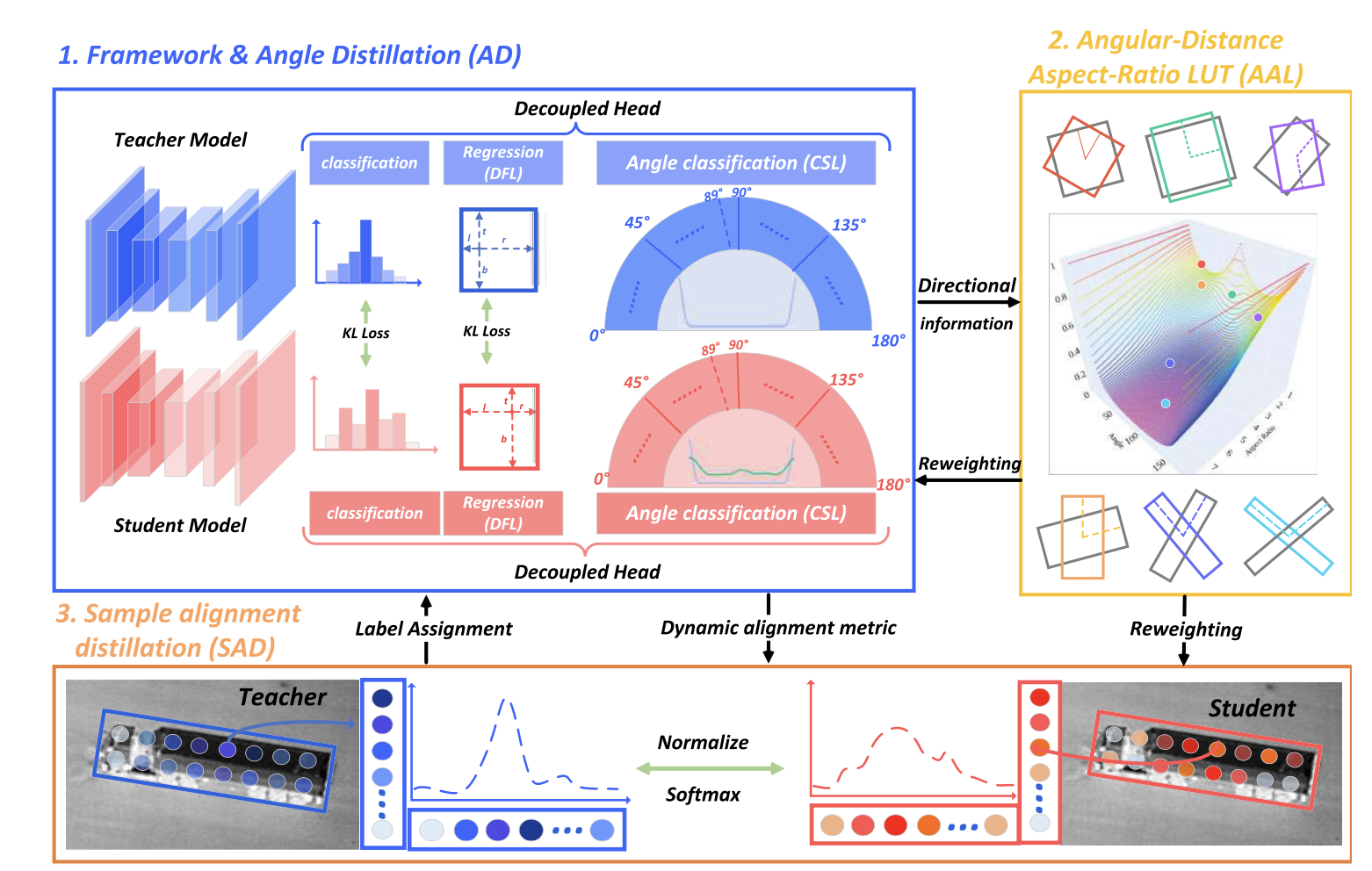

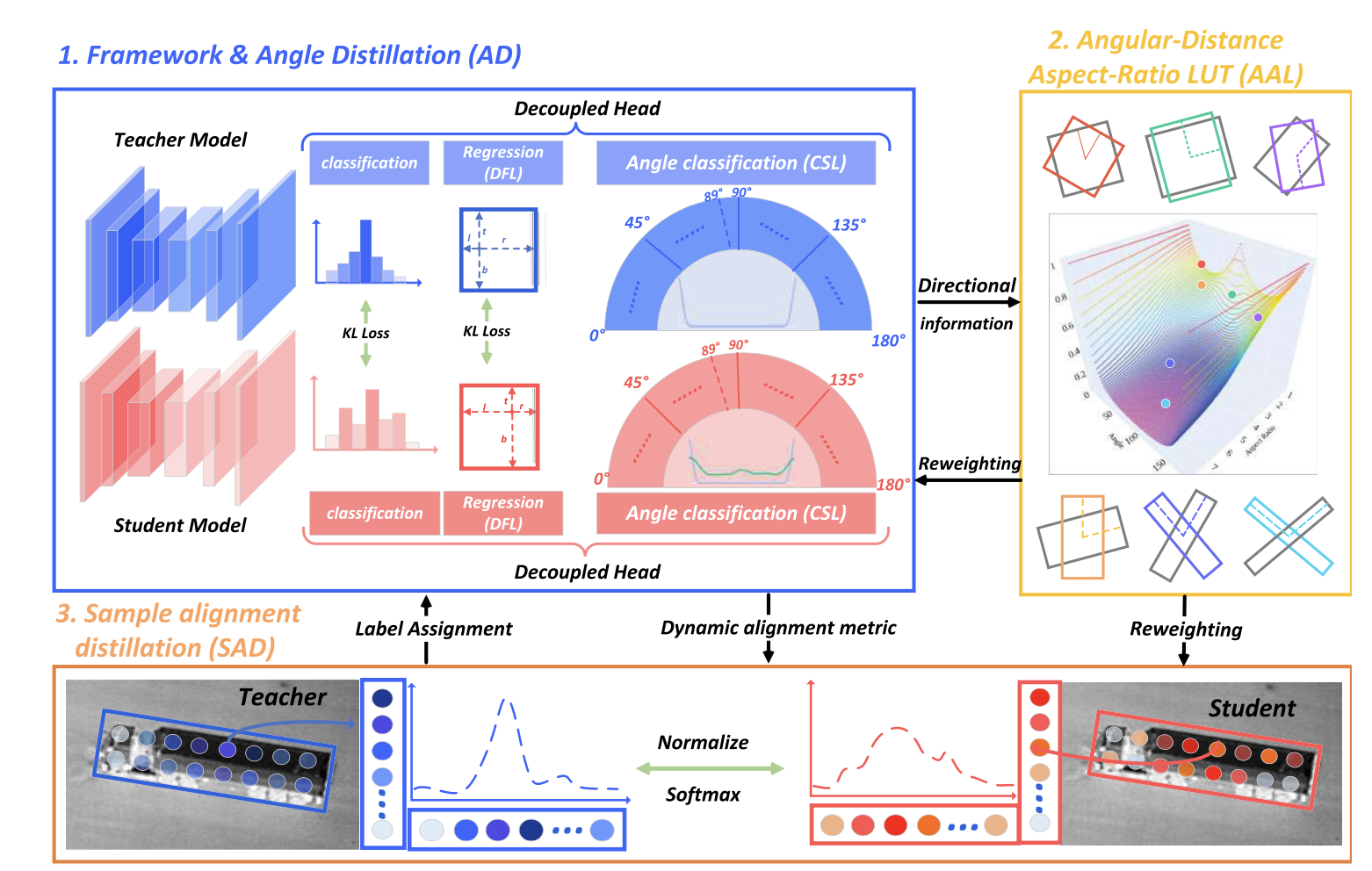

把头部解耦,进一步分解成三个子任务分支:回归分支、分类分支和角度分类分支(CSL)。

Angle Distillation

就是使用CSL将角度分为180个类别,然后使softmax将这些输出的logit转变为类别概率分布:

pθτ=softmax(Sθ,τ)(3)qθτ=softmax(Tθ,τ)(4)Lθ=LCE(Sθ,θcsl)+λθLKL(pθτ∣∣qθτ)(5)

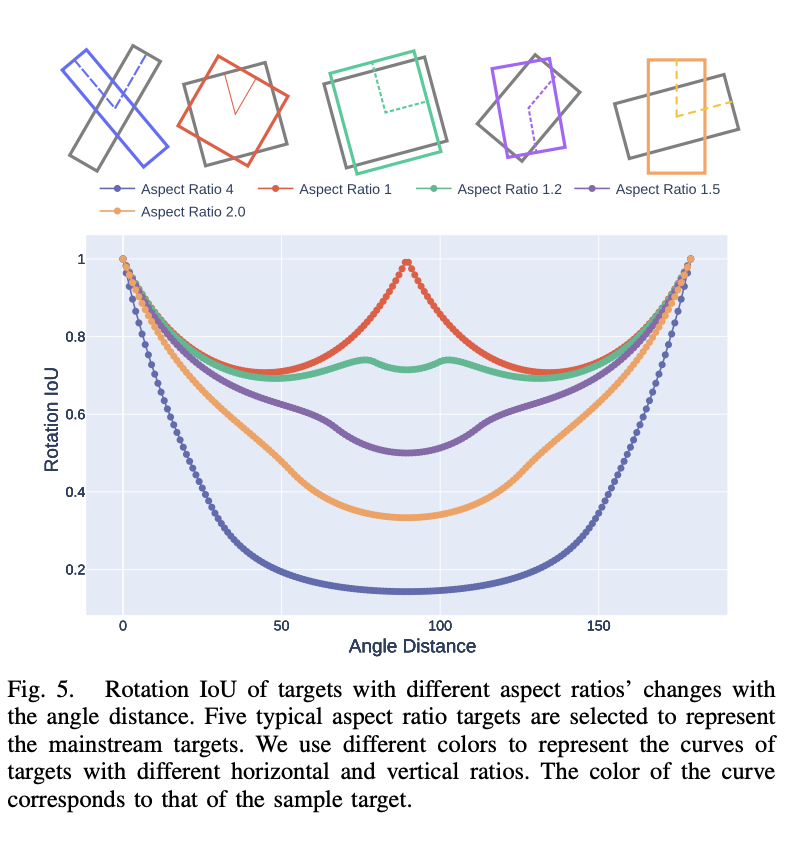

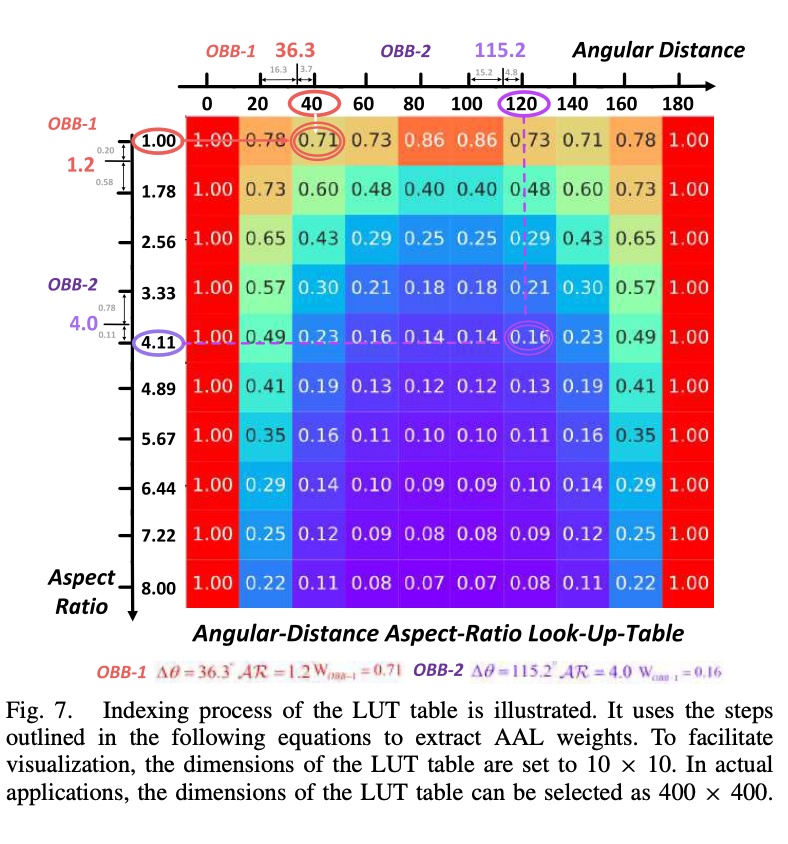

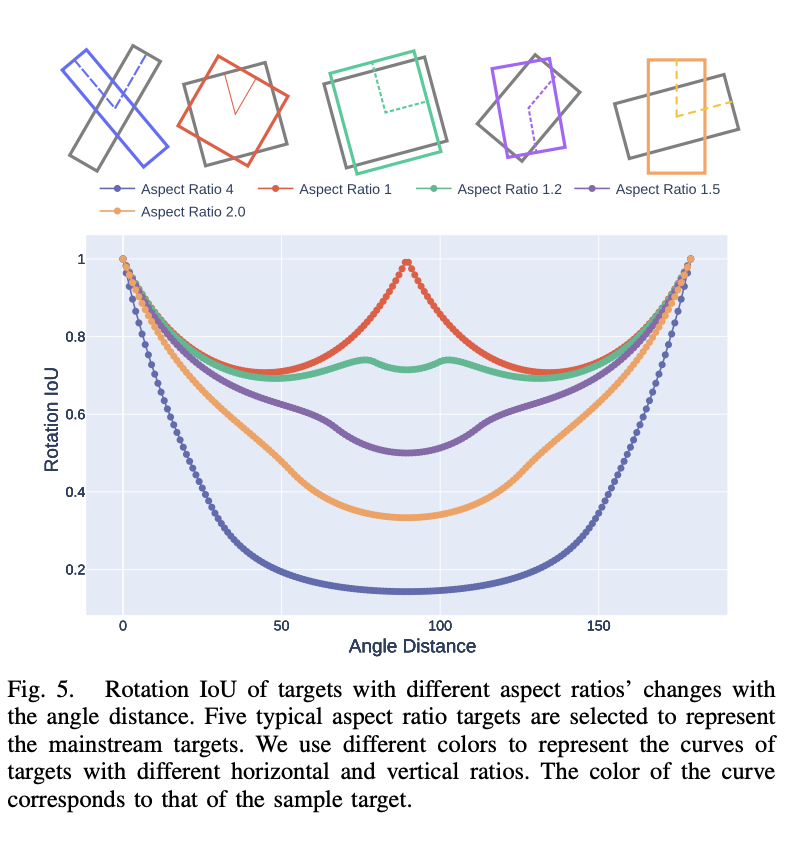

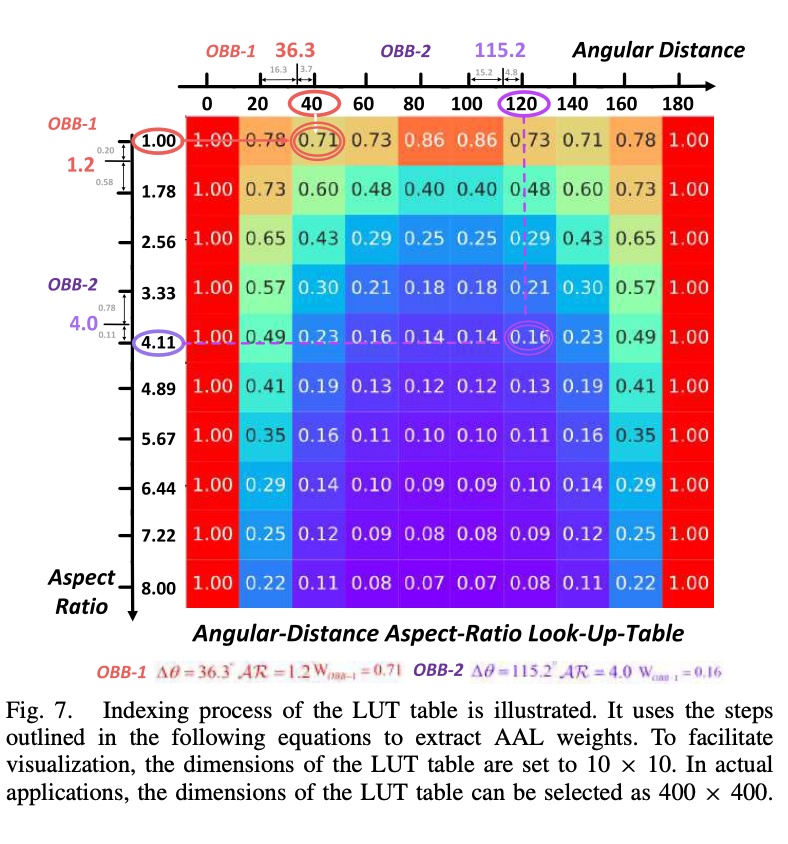

Agnular Distance Aspect Lookup Table

提出了角度距离横纵比(权重)路由表,用于解决角度周期性问题和类正方形问题:

W∗(θ)V(AR)=∣sin(V(AR)×(Δθ))∣={2,1,AR>rotherwise.

做了一个离散的建模映射,得到权重,并用这个权重重新加权分类分支、回归分支、角度分类分支的损失。

总之,通过这个AAL来提高模型对角度距离和横纵比的敏感性,解决角度周期性问题和类正方形问题。

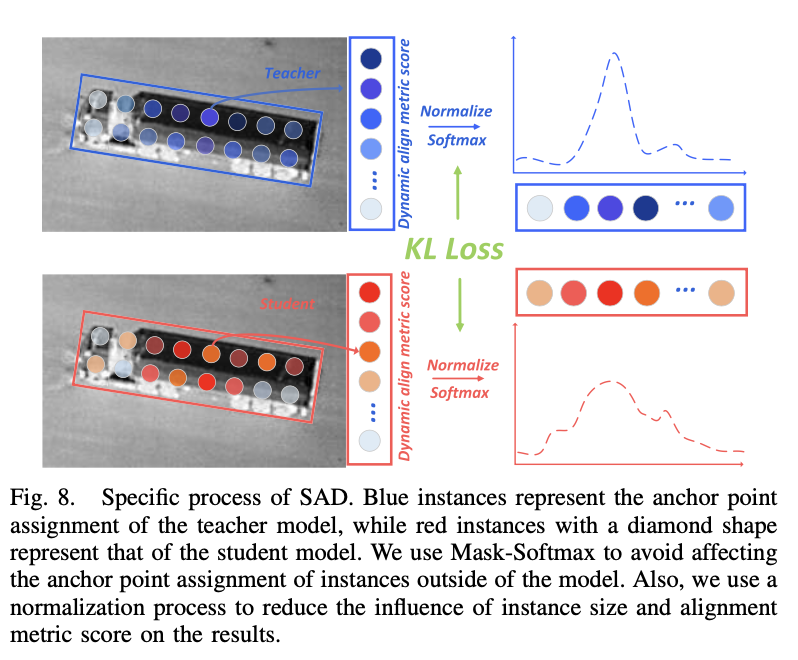

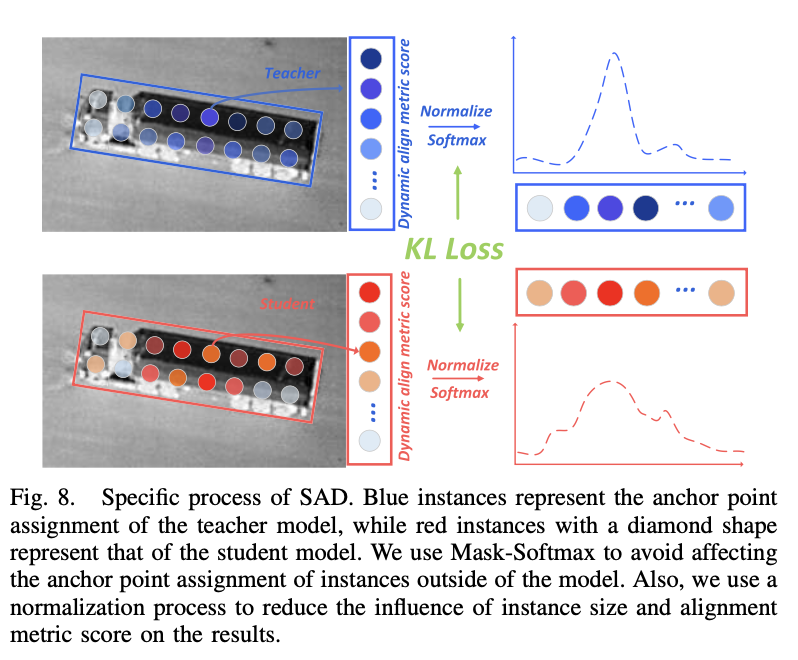

Sample Alignment Distillation

这一部分是专门针对单阶段目标检测的,对anchor point做一个蒸馏。

Loss Function

最后的Loss由四个类别组成,分别是回归分支损失,分类分支损失,角度分类分支损失和SAD模块

- 回归分支损失:IOU:使用的是Generlized focal loss, GIOU + 四条边softmax概率分布

LIoU=1−GloU(B,Bˉ)Lreg=i=1∑NposS^i(LIoU+λregLKL(pregiτ∣∣qregiτ)).

- 分类分支损失:使用的是VarifocalNet中的VFL

Lclass=i=1∑NposVFL(pi,S^i)+λclsLKL(pclassτ∣∣qclassτ).

Lθ=i=1∑NposS^i(LCE(Sθi,θcsli)+λθLKL(pθiτ∣∣qθiτ))

LLA=−K1i=1∑Kj=1∑Njt^ijlogs^ijt^ij.

最后的总损失函数L:

L=λ1Lreg+λ2Lclass+λ3Lθ+λ4LLA.

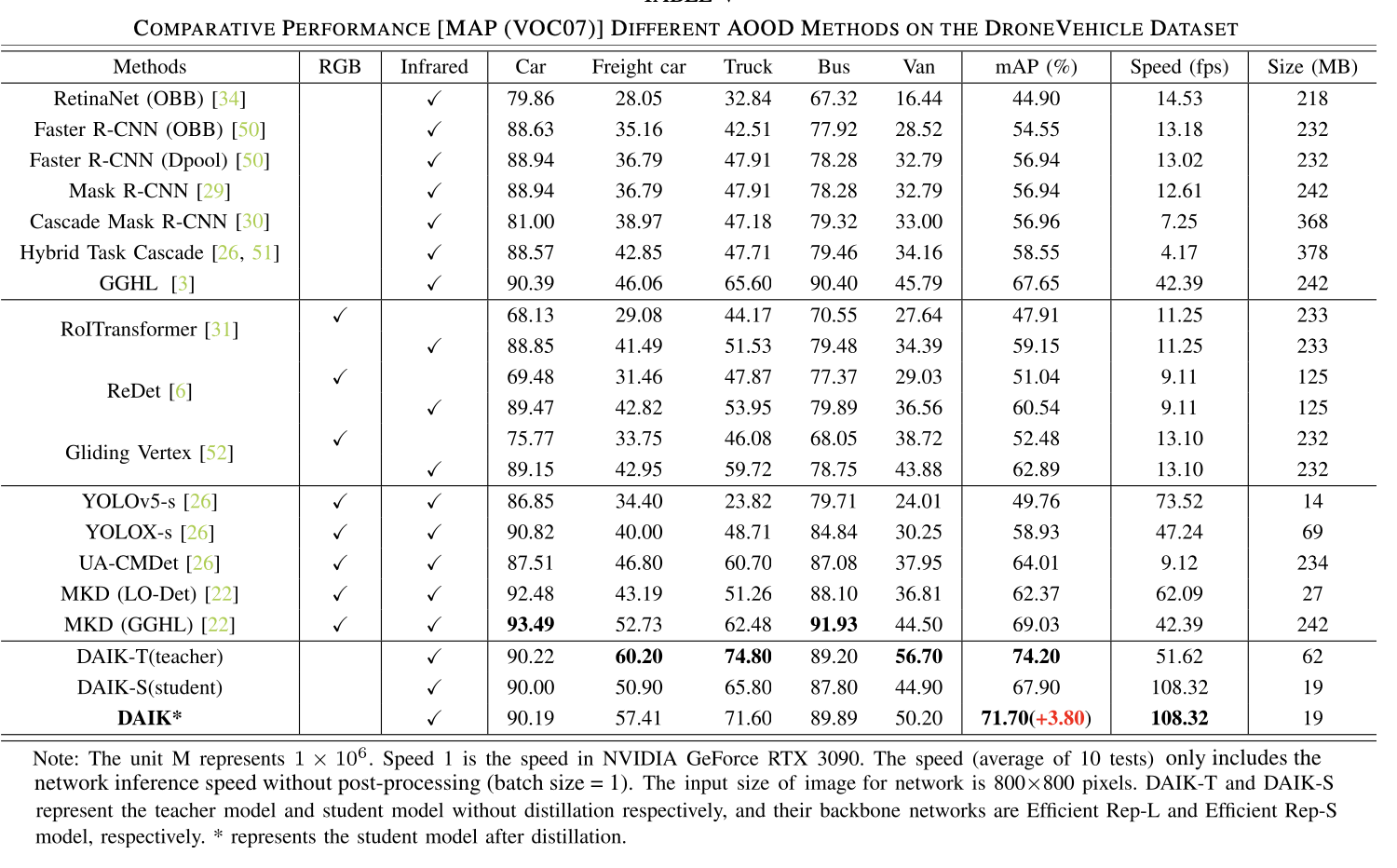

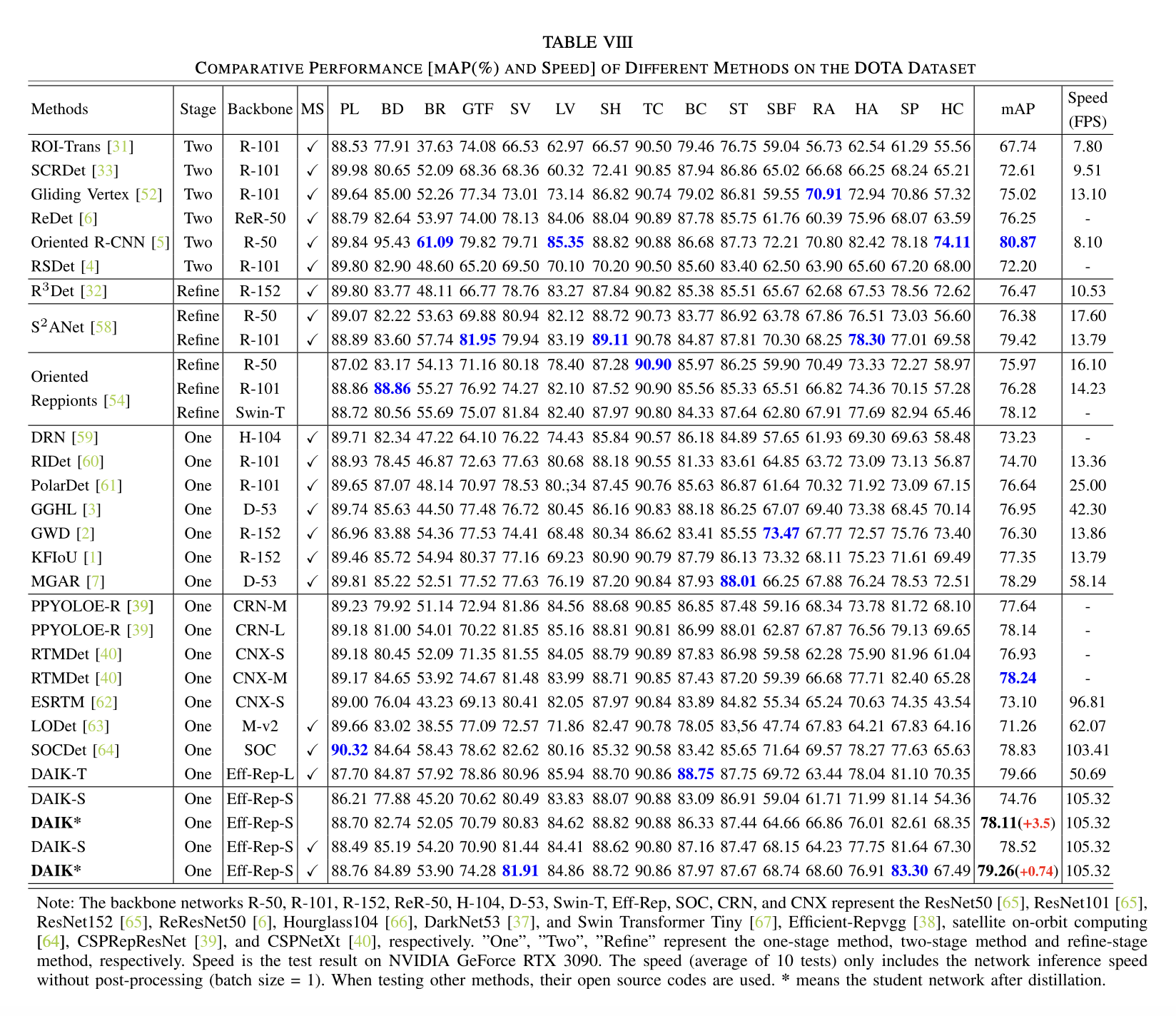

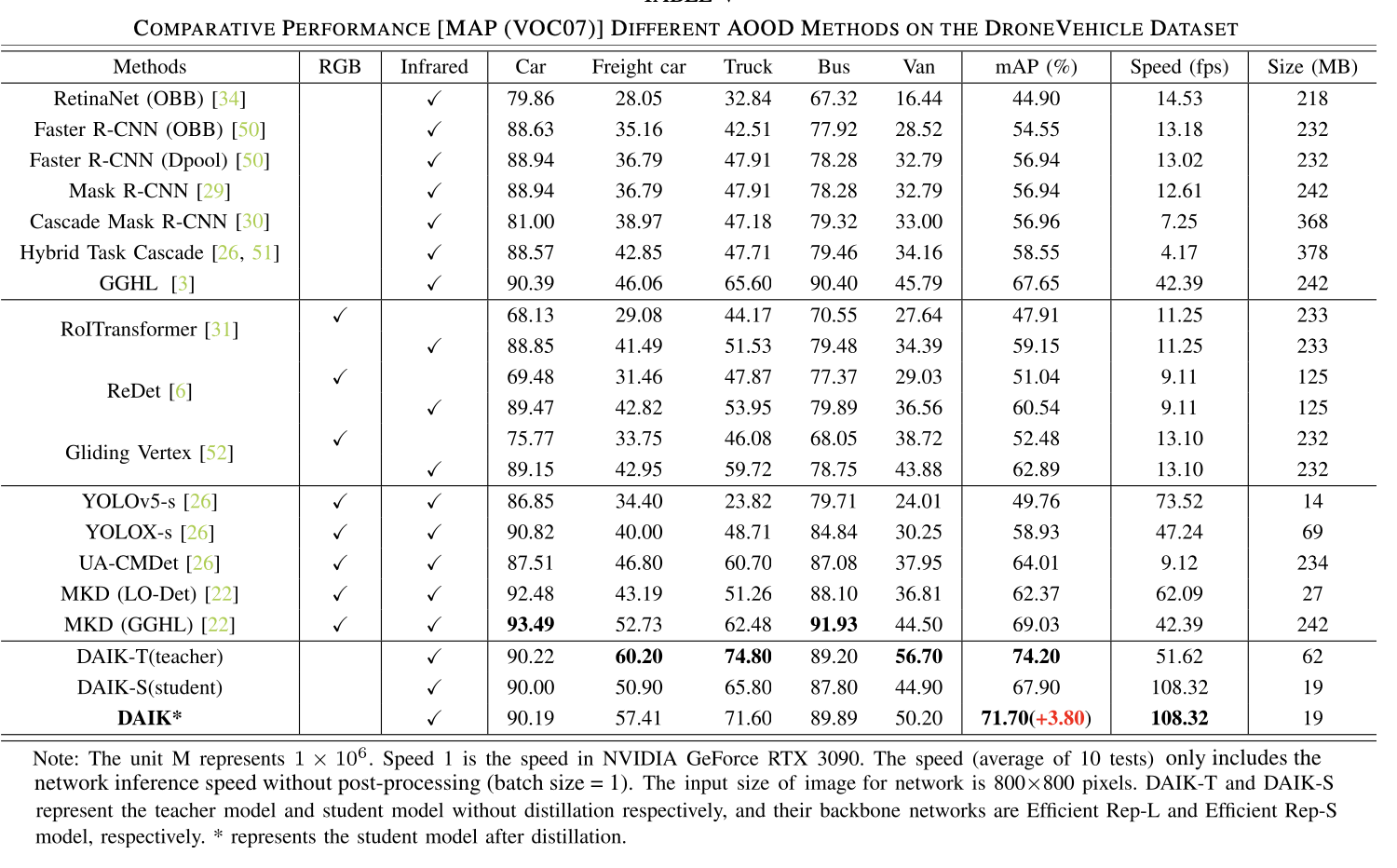

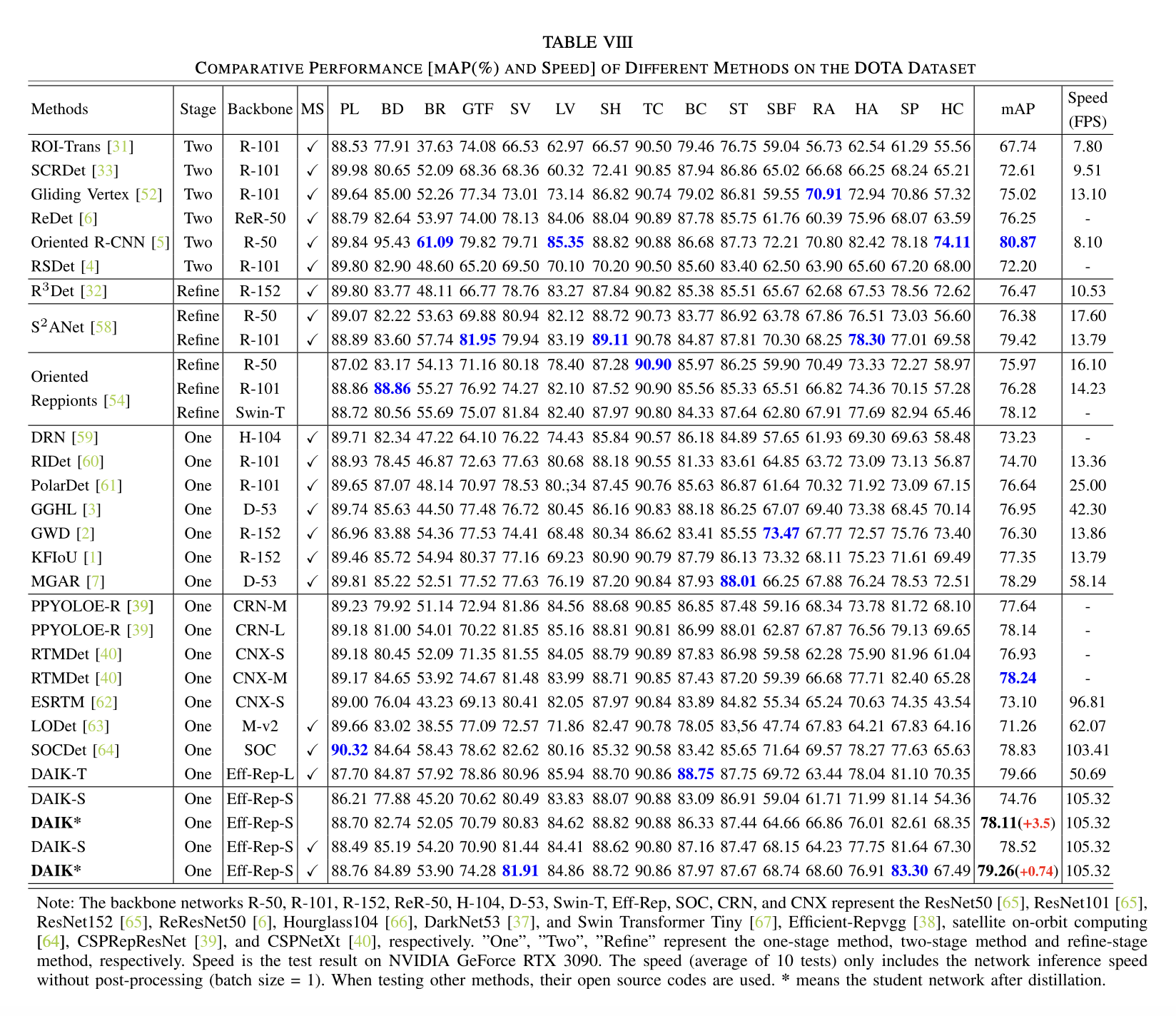

Result

其他

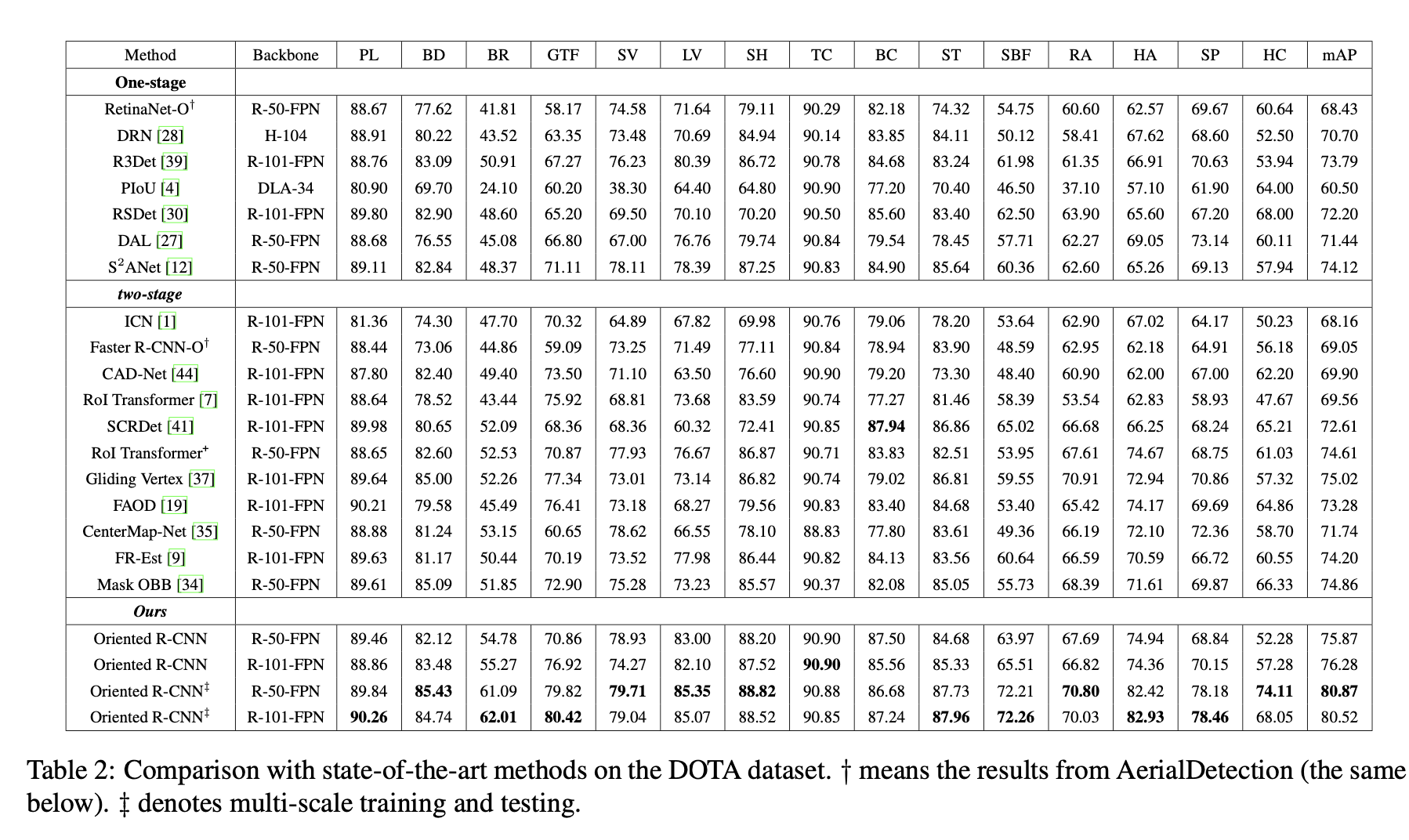

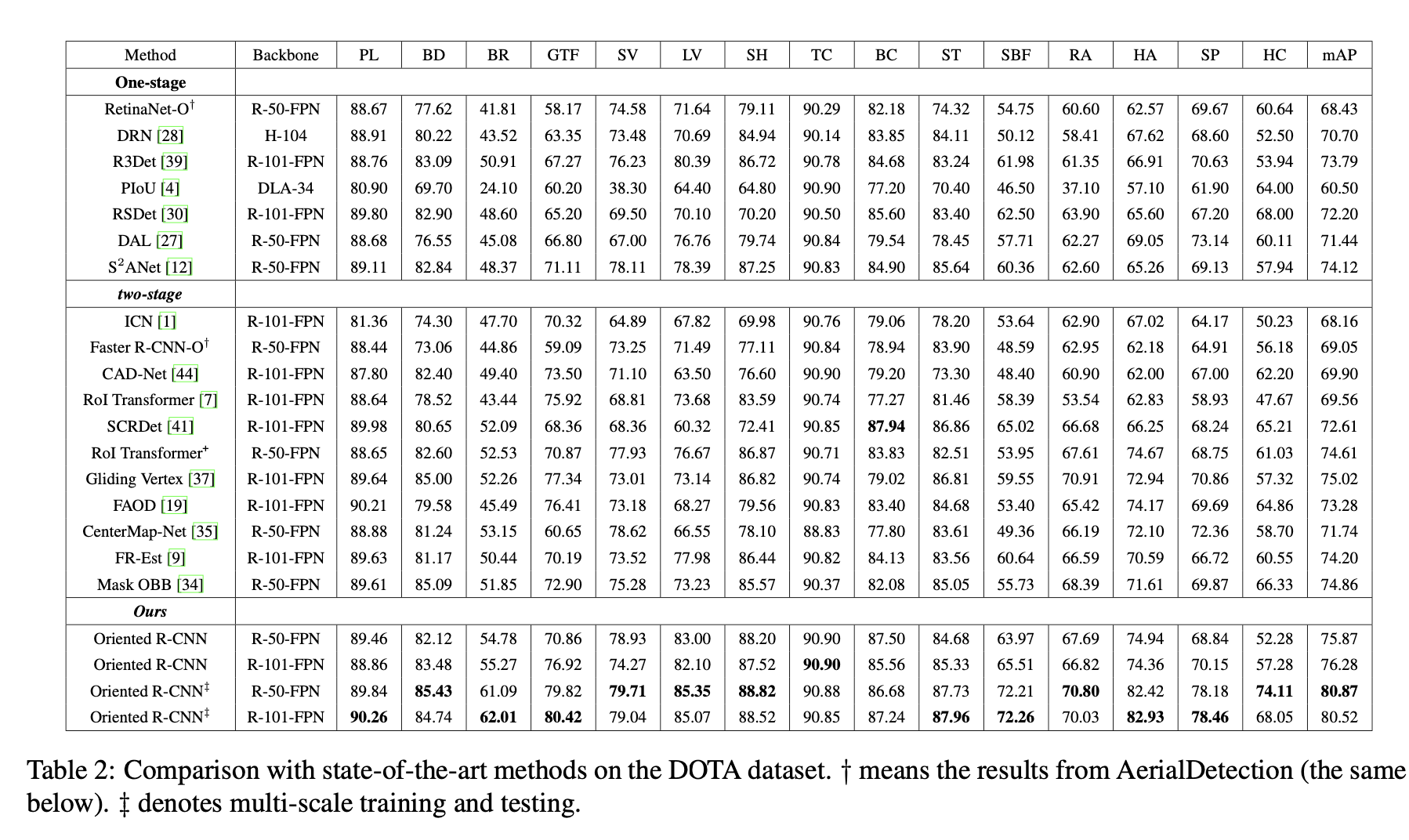

Oriented-rcnn 教师网络 resnet101网络测试结果:

没有蒸馏效果的好